- Best-IA Newsletter

- Posts

- Boletín Semanal Best-IA #121

Boletín Semanal Best-IA #121

Aprende IA, día a día

Tutoriales

Convierte las pestañas del navegador en una app personalizada con GenTabs en Disco, el nuevo experimento de Google Labs

Diseña sitios web y aplicaciones épicas con Gemini 3

Noticias

OpenAI presenta GPT-5.2: un salto en rendimiento real y uso profesional

OpenAI ha anunciado GPT-5.2, su modelo más avanzado hasta la fecha, centrado en mejorar la fiabilidad, el razonamiento práctico y la ejecución de tareas complejas en entornos reales, tanto para usuarios como para desarrolladores.

🔑 Claves del lanzamiento

Mayor inteligencia general: GPT-5.2 muestra un rendimiento superior en tareas profesionales y de resolución de problemas complejos, acercándose a niveles expertos en múltiples dominios.

Contexto largo más robusto: maneja documentos extensos y proyectos de gran escala manteniendo coherencia, precisión y seguimiento de objetivos a lo largo de miles de tokens.

Agentes y uso de herramientas: mejora la capacidad de planificar, usar herramientas externas y ejecutar flujos de trabajo multietapa con menor supervisión humana.

Código y productividad: avances claros en generación, depuración y comprensión de código, así como en tareas habituales de oficina y análisis de datos.

Multimodalidad más precisa: comprensión visual mejorada, con interpretaciones más fiables de imágenes combinadas con texto.

🎯 GPT-5.2 refuerza la tendencia hacia modelos menos conversacionales y más operativos, pensados para trabajar como sistemas cognitivos aplicados, un paso clave en la integración de la IA en procesos profesionales complejos y sostenidos.

Google acelera Gemini: traducción en tiempo real, voz avanzada y agentes listos para producción

Esta semana Google ha desplegado una batería de lanzamientos que refuerzan una idea clara: Gemini deja de ser solo un modelo para convertirse en infraestructura operativa. Traducción, voz, audio nativo, agentes de investigación y nuevas APIs avanzan de forma coordinada.

🔑 Claves de los lanzamientos

Traducción con Gemini en Search y Translate: mejoras SOTA en traducción contextual y natural, junto con Live Translation (beta) speech-to-speech en tiempo real directamente en auriculares, orientado a uso cotidiano.

Gemini 2.5 Text-to-Speech (Flash y Pro): salto cualitativo en control de estilo, ritmo y diálogos multi-speaker estables en 24 idiomas, con una clara separación entre tiempo real (Flash) y audio premium (Pro).

Gemini 2.5 Flash Native Audio (Live API): audio conversacional nativo con mejor seguimiento de instrucciones, function calling más fiable y soporte para workflows complejos sin perder fluidez.

Google Labs: Disco + GenTabs: experimento que usa Gemini 3 para convertir pestañas del navegador en apps y flujos temporales, apuntando al browser como entorno de ejecución.

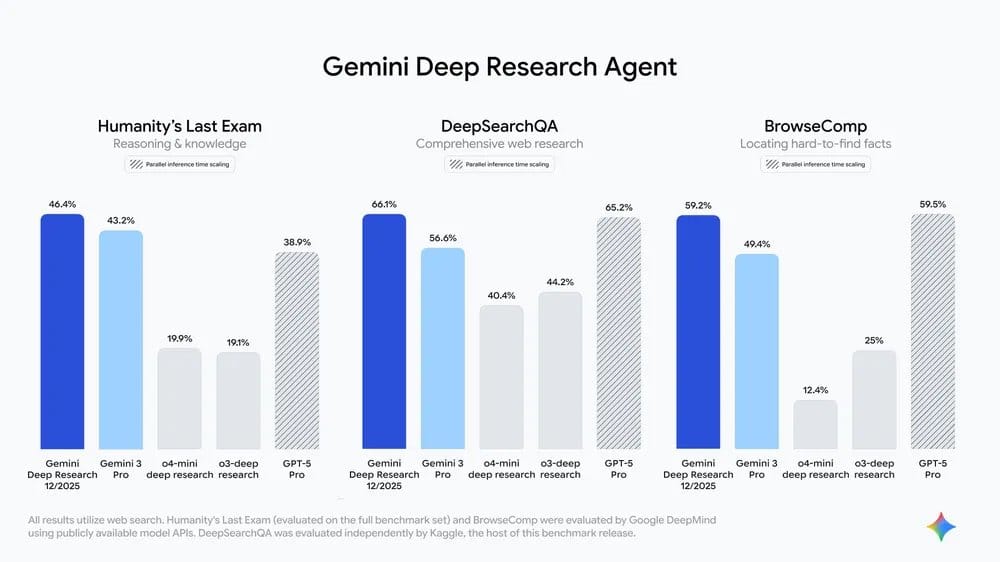

Gemini Deep Research Agent en la API: agente de investigación autónoma basado en Gemini 3 Pro, con alto rendimiento en benchmarks y capacidad real para tareas largas y multi-paso.

Interactions API: API unificada para modelos y agentes, con estado persistente, ejecución en background y soporte MCP, consolidando una base sólida para agentes autónomos.

🎯 Google consolida una estrategia clara: voz, traducción y agentes avanzan como un sistema integrado orientado a tareas largas, autónomas y multimodales, reforzando a Gemini como infraestructura base para aplicaciones reales y sostenidas de IA.

Mistral lanza Devstral 2 y Vibe CLI: automatización de código abierta y eficiente

Mistral presenta Devstral 2, una nueva familia de modelos open-source orientados a automatización avanzada de código, junto con Vibe CLI, un terminal agentico nativo para trabajar de forma autónoma sobre bases de código completas.

🔑 Claves del lanzamiento

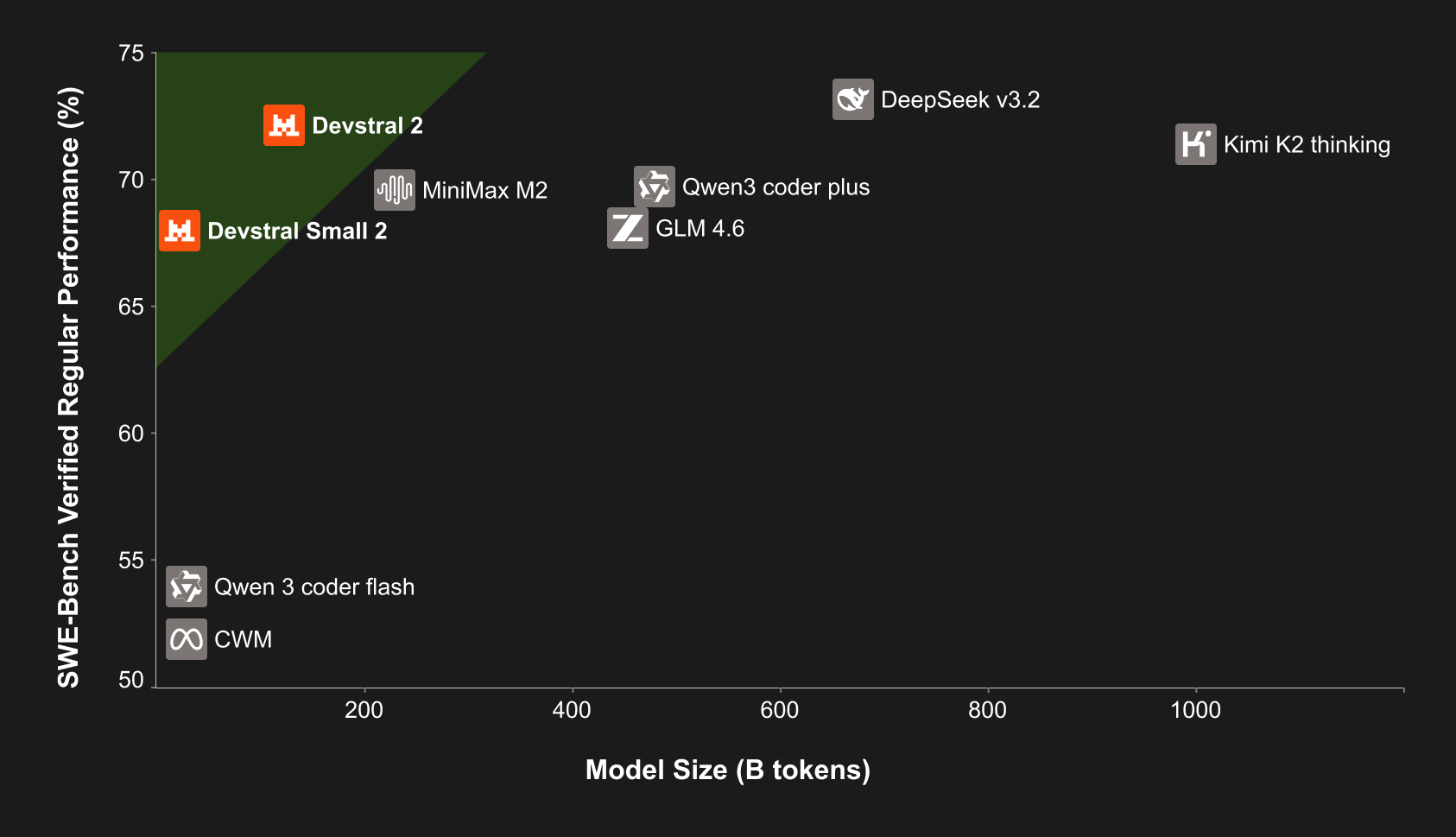

Devstral 2 (open-source): modelo de nueva generación para coding que alcanza 72,2 % en SWE-bench Verified, con muchos menos parámetros que sus rivales y hasta 7× más eficiente en costes que Claude Sonnet.

Contexto largo (256K): diseñado para comprender y modificar proyectos completos, no solo fragmentos aislados de código.

Vibe CLI: terminal agéntico que explora repositorios, edita archivos y ejecuta cambios de forma autónoma, integrándose directamente en el flujo del desarrollador.

Devstral Small 2 (24B): versión optimizada para hardware de consumo, mantiene el contexto de 256K y permite desarrollo local, privado y rápido.

Enfoque práctico: automatización real de tareas de ingeniería de software, más allá de simples sugerencias de código.

🎯 Mistral refuerza la apuesta por modelos abiertos y agentes prácticos, mostrando que el avance en IA para programación no depende solo de escalar parámetros, sino de eficiencia, contexto largo y herramientas nativas pensadas para desarrolladores reales.

Microsoft impulsa la voz en tiempo real y el aprendizaje de agentes con VibeVoice y Agent Lightning

Microsoft ha presentado dos lanzamientos clave esta semana que atacan frentes distintos pero complementarios: voz conversacional en tiempo real y mejora continua de agentes mediante refuerzo, ambos con un enfoque claramente técnico y orientado a producción.

🔑 Claves de los lanzamientos

VibeVoice (open source): nuevo modelo de generación de voz en tiempo real y latencia ultrabaja, con soporte para nueve idiomas, incluido español.

Conversaciones largas y multi-voz: VibeVoice permite diálogos prolongados con múltiples hablantes estables, pensado para asistentes, voice agents y aplicaciones interactivas.

Agent Lightning: framework que desacopla cómo actúan los agentes de cómo se entrenan, convirtiendo cada paso del agente en datos para reinforcement learning.

Mejora sin reescrituras: permite optimizar el rendimiento de agentes con cambios mínimos o casi cero en el código, facilitando la iteración continua.

Enfoque developer-first: ambas propuestas están pensadas para integrarse fácilmente en pipelines reales, no como demos experimentales.

🎯 Microsoft refuerza una línea clara: voz natural en tiempo real y agentes que aprenden de su propia ejecución, apuntando a sistemas autónomos más refinables, persistentes y adaptativos sin fricción para los desarrolladores.

Zhipu AI lanza GLM-4.6V: multimodal open-source con herramientas nativas

Zhipu AI presenta GLM-4.6V, una nueva serie open-source de modelos multimodales diseñada para agentes avanzados. Combina visión, texto y código con uso nativo de herramientas, apuntando a despliegues tanto en clústeres como en entornos locales.

🔑 Claves del lanzamiento

Serie GLM-4.6V: incluye un modelo 106B de alto rendimiento y GLM-4.6V-Flash (9B) optimizado para baja latencia y despliegue local.

Multimodalidad nativa end-to-end: entrada y salida sobre texto, imágenes, gráficos, capturas y código, con razonamiento visual completo.

Function Calling nativo en visión: primera vez en la familia GLM, habilitando agentes multimodales que usan herramientas sin capas externas.

Contexto largo (128K tokens): comprensión y planificación sobre tareas extensas, flujos complejos y sesiones prolongadas.

Casos prácticos avanzados: búsqueda web visual, replicación de frontends desde screenshots y automatización agentica real.

🎯 GLM-4.6V refuerza la carrera open-source hacia agentes multimodales completos, combinando contexto largo, visión operativa y herramientas nativas, y elevando el listón para desarrollos autónomos accesibles y escalables en IA.

Además, AutoGLM, su modelo de visión-lenguaje que entiende las pantallas de los teléfonos y actúa como un agente móvil autónomo, pasa a ser de código abierto.

Runway presenta GWM-1: modelos del mundo para simulación en tiempo real

Runway da un paso más allá del vídeo generativo con GWM-1, su primera familia de General World Models: sistemas capaces de construir una representación interna de un entorno y simularlo en tiempo real, de forma interactiva y controlable.

🔑 Claves del anuncio

Modelo del mundo en tiempo real: GWM-1 es un modelo autoregresivo, construido sobre Gen-4.5, que genera frame a frame y permite control directo mediante acciones como cámara, comandos robóticos o audio.

Tres variantes especializadas:

GWM Worlds para entornos explorables, GWM Avatars para personajes conversacionales condicionados por audio y GWM Robotics para simulación y entrenamiento de agentes.Interacción y control: no sólo genera vídeo, sino que responde a acciones del usuario, acercándose a entornos simulados navegables similares a Genie 3 de Google.

Simulación como motor de aprendizaje: enfocado a entrenar sistemas mediante prueba y error acelerado en mundos virtuales, evitando costes y riesgos del mundo real.

Camino hacia la unificación: Runway trabaja en integrar distintos dominios y espacios de acción bajo un único modelo base de mundo.

🎯 Los modelos del mundo apuntan a una IA que aprende interactuando y simulando, no solo leyendo texto, abriendo una vía clave para avances en robótica, ciencia y sistemas autónomos entrenados a gran escala.

Robots

Pudu Robotics presenta la serie D5: robots cuadrúpedos autónomos para entornos reales

Pudu Robotics lanza la serie PUDU D5, una nueva generación de robots cuadrúpedos autónomos de grado industrial, diseñada para operar con fiabilidad en entornos complejos, dinámicos y no estructurados, más allá del laboratorio.

Reflexiones Finales

Actualización de GPT 5.2, Google supera a OpenAI y el colapso de las empresas en 2026

La carrera por la IA de frontera ha entrado en fase de aceleración no lineal, donde mejoras aparentemente “incrementales” (GPT-5.2, Gemini, agentes) están empujando a una reconfiguración abrupta del trabajo, las empresas y el poder económico, con 2026 como punto de ruptura probable.